Nvidia bringt neue Serverplattform für HPC und KI

Auf der diesjährigen GTC Taiwan hat Nvidia die Einführung der neuen Cloud-Server-Plattform HGX-2 angekündigt. Mit ihr lassen sich Multi-Precision-Workloads beschleunigen, außerdem bietet sie auf Basis von zwei Petaflops eine rekordverdächtige Verarbeitungsleistung für KI-Anwendungen und High Performance Computing (HPC).

Die Cloud-Server-Plattform HGX-2 enthält flexibel nutzbare Multi-Precision-Computing-Funktionen. Sie ermöglicht präzise Berechnungen mit FP64 und FP32, beispielsweise für wissenschaftliche Berechnungen und Simulationen, und unterstützt zugleich FP16 und Int8 für das KI-Training und Inferenzen. Nvidia will mit der neuen Plattform die Anforderungen der immer größer werdenden Anzahl von Anwendungen erfüllen, die HPC mit künstlicher Verbindung miteinander kombinieren.

Leistungsstarke Server-Plattform vereint HPC und KI

Zahlreiche Computerhersteller haben bereits erklärt, dass sie die Einführung von Systemen auf Basis der HGX-2-Plattform planen. Die Cloud-Server-Plattform können Hersteller sozusagen als Baustein für fortschrittliche Systeme für HPC und KI nutzen. Die Plattform erreichte beim ResNet-50-Training eine Verarbeitungsgeschwindigkeit von 15.500 Bildern pro Sekunde und kann auf diese Weise bis zu 300 konventionelle CPU-Server ersetzen.

Jensen Huang, Gründer und CEO von Nvidia, erklärte auf der GPU Technology Conference Taiwan Ende Mai: "Die Welt des Computing hat sich verändert. Die CPU-Skalierung hat sich verlangsamt, während die Nachfrage nach Rechenleistung rasant steigt. HGX-2 mit Tensor-Core-Grafikprozessoren bietet der Branche eine leistungsstarke, vielseitige Computing-Plattform, die HPC und KI vereint, um selbst größte Herausforderungen zu meistern."

Architektur der HGX-2 überzeugt Server-Hersteller

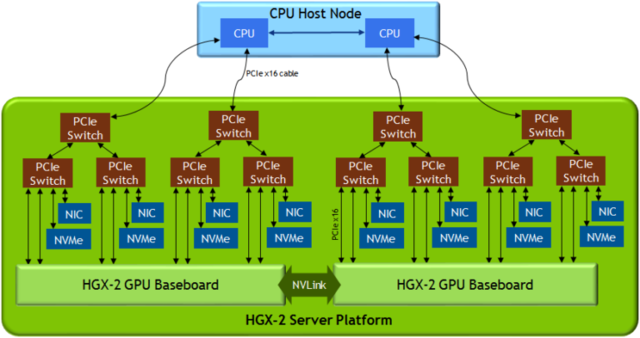

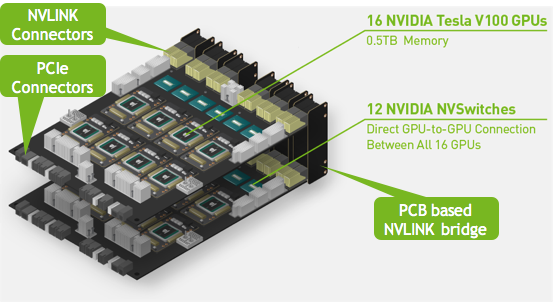

Die HGX-2-Serverplattform bietet noch nicht dagewesene Features wie Nvidia NVSwitch Interconnect Fabric, mit der sich 16 Tesla-V100-Tensor Core-GPUs nahtlos zu einem einzigen Grafikprozessor mit zwei Petaflops verbinden lassen. Das erste, auf HGX-2 basierende System ist das kürzlich angekündigte DGX-2. HGX-2 ist das Nachfolgesystem von Nvidia HGX-1, das erstmals auf der Computex 2017 präsentiert wurde. Die Referenzarchitektur von HGX-1 hatte bei Serverherstellern und Rechenzentrumsbetreibern wie Amazon Web Services, Facebook und Microsoft großen Zuspruch gefunden.

Einige Serverhersteller wie Lenovo, QCT, Supermicro und Wiwynn haben bereits angekündigt, noch in diesem Jahr neue Systeme mit integrierter HGX-2-Architektur auf den Markt zu bringen. Außerdem entwickeln derzeit führende Original-Design-Hersteller (ODMs) wie Foxconn, Inventec, Quanta Cloud Technology und Wistron HGX-2- basierte Systeme für den Einsatz in einigen der weltweit größten Cloud-Rechenzentren.

Quanta Cloud Technology (QCT), spezialisiert auf Cloud-Hardware sowie Software und Services für Rechenzentren, kündigte an, die HGX-2-Architektur für die eigenen leistungsstarken Computing-Plattformen der QuantaGrid-Serie nutzen. Die neuen Serversysteme sollen die Anforderungen zukünftiger KI- und HPC-Lösungen erfüllen. "Aufgrund des Aufkommens einer Vielzahl von KI-Anwendungen arbeitet QCT eng mit NVIDIA zusammen, um sicherzustellen, dass unsere Kunden von den neuesten und besten GPU-Technologien profitieren", erklärte Mike Yang, Präsident von QCT. "Wir freuen uns sehr, als HGX-2-Launch-Partner unser Portfolio für GPU-Computing-Lösungen mit dieser zukunftsweisenden Lösung AI-basierter Cloud Anwendungen zu erweitern."

Optimaler Mix aus GPUS, CPUs und Interconnect Fabrics

HGX-2 zählt zu den GPU-beschleunigten Serverplattformen von Nvidia, die eine breite Palette von KI-, HPC- und Accelerated-Computing-Workloads mit hoher Leistung abdeckt. Die Plattformen, unterstützt von zahlreichen Serverherstellern, passen sich dem Server-Ökosystem des Rechenzentrums an, indem sie die optimale Mischung aus GPUs, CPUs und Interconnects für diverse Trainings-, Inferenz- und Supercomputing- Anwendungen bieten. Anwenderunternehmen können eine spezifische Serverplattform wählen, die ihrem jeweils benötigten Computing-Workload-Mix entspricht und die beste Leistung ihrer Klasse bietet.

Autor: Stefan Girschner